Ολοι οι Ελληνες πατριωτες επιλεγουν το Ελληνικο κοινωνικο δικτυο https://Hellasbook.gr ελα μαζι μας γιατι ειναι λογικο πια να μην ειμαστε στους ξενους!!

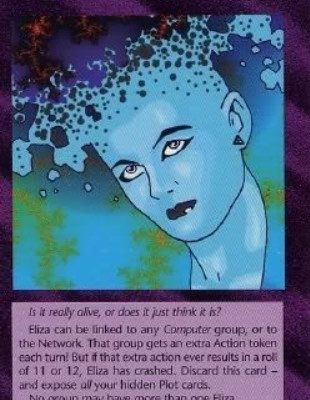

Φαινόμενο ΕLIZA…

Ολοι οι Ελληνες πατριωτες επιλεγουν το Ελληνικο κοινωνικο δικτυο https://Hellasbook.gr ελα μαζι μας γιατι ειναι λογικο πια να μην ειμαστε στους ξενους!!

Ti είναι αυτή η εικόνα στην γνωστή κάρτα Ιλλουμινάτι;

Το φαινόμενο ELIZA, στην επιστήμη των υπολογιστών, είναι η τάση των ανθρώπων ασυνείδητα να θεωρούν ότι οι συμπεριφορές των υπολογιστών είναι ανάλογες με τις ανθρώπινες .Δηλαδή, ο ασυνείδητος ανθρωπομορφισμός των μηχανών.

Πιο συγκεκριμένα, το φαινόμενο ELIZA αναφέρεται στην «ευαισθησία των ανθρώπων να αντιλαμβάνονται πολύ περισσότερη κατανόηση από ό, τι δικαιολογούν, σε σειρές από σύμβολα – ειδικές λέξεις – που συνδέονται μεταξύ τους από υπολογιστές.

Ένα μικρό παράδειγμα της συγκεκριμένης μορφής του Eliza, που δόθηκε από τον Douglas Hofstadter, περιλαμβάνει ένα αυτοματοποιημένο ταμείο που εμφανίζει τις λέξεις “ΕΥΧΑΡΙΣΤΩ” στο τέλος μιας συναλλαγής. Ένας (πολύ) απρόσεκτος παρατηρητής μπορεί να πιστεύει ότι η μηχανή εκφράζει πραγματικά ευγνωμοσύνη. Ωστόσο, το μηχάνημα το μόνο που κάνει είναι να εκτυπώνει μια προγραμματισμένη σειρά συμβόλων.

Γενικότερα το ELIZA περιγράφει κάθε κατάσταση όπου, με βάση αποκλειστικά την ΄΄εξαγωγή’’ από υπολογιστικά συστήματα,΄΄ χρήστες αντιλαμβάνονται ψευδώς ότι τα συστήματα υπολογιστών έχουν ” ιδιότητες και ικανότητες τις οποίες το λογισμικό τους δεν μπορεί να επιτύχει” “αντικατοπτρίζουν μια πολύ μεγαλύτερη ιδιότητα από ό, τι υπάρχει στην πραγματικότητα”. Τόσο στις ειδικές όσο και στις γενικές του μορφές, το φαινόμενο ELIZA είναι αξιοσημείωτο ότι συμβαίνει ακόμη και όταν οι χρήστες του συστήματος γνωρίζουν την καθορισμένη μορφή που παράγεται από το σύστημα.

Η ανακάλυψη του φαινομένου ELIZA δεν ήταν απλά σημαντική εξέλιξη στην τεχνητή νοημοσύνη, αλλά περισσότερο μία αρχή κοινωνικής μηχανικής!

Το 1966 κατασκευάσθηκε και αναπτύχθηκε το chatterbot ELIZA από τον επιστήμονα υπολογιστών MIT .Joseph Weizenbaum .

Κατά την εκτέλεση του σεναρίου DOCTOR του Weizenbaum, η ELIZA έπαιζε τον ρόλο του ψυχοθεραπευτή Rogerian, κυρίως διατυπώνοντας τις απαντήσεις του «ασθενούς» ως ερωτήσεις:

Ανθρωπος: Λοιπόν, ο φίλος μου με έκανε να έρθω εδώ.

ΕLΙΖΑ: Ο φίλος σου σε έκανε να έρθεις εδώ;

Άνθρωπος: Λέει πολλές φορές ότι έχω κατάθλιψη .

ΕLΙΖΑ: Λυπάμαι που το ακούω ότι έχετε κατάθλιψη.

Άνθρωπος: Είναι αλήθεια. Δεν είμαι χαρούμενος.

ΕLΙΖΑ: Πιστεύεις το ότι έρχεσαι εδώ θα σε βοηθήσει να μην είσαι δυστυχισμένος;

Το ELIZA ήταν ένα απλό πρόγραμμα υπολογιστή. Αναζητούσε τη λέξη-κλειδί στη φράση ενός χρήστη και στη συνέχεια την αντανακλούσε με τη μορφή μιας απλής φράσης ή ερώτησης. Όταν δεν τα κατάφερνε, επέστρεφε σε ένα σύνολο γενικών προτροπών όπως “παρακαλώ συνεχίστε” ή “πείτε μου περισσότερα”. Ο Weizenbaum είχε προγραμματίσει την ELIZA να αλληλεπιδρά με το στυλ ενός ψυχοθεραπευτή και ήταν αρκετά πειστικό. Εδινε την ψευδαίσθηση της ενσυναίσθησης παρόλο που ήταν απλός κώδικας.

Το ELIZA ήταν ένα από τα πρώτα προγράμματα υπολογιστών που μπορούσαν να μιμηθούν πειστικά την ανθρώπινη συνομιλία, την οποία ο ίδιος ο Weizenbaum την έβρισκε ως ιδέα λίγο ενοχλητική. Δεν περίμενε ότι οι άνθρωποι θα γοητευτούν τόσο πολύ. Ανησυχούσε ότι οι χρήστες δεν θα καταλάβουν πλήρως ότι μιλούσαν σε ηλεκτρονικά κυκλώματα και προβληματιζόταν για τις δυσμενείς επιπτώσεις μηχανών που θα μπορούσαν να μιμηθούν στο μέλλον περισσότερο ακόμα την αίσθηση της ανθρώπινης κατανόησης.

Ο Weizenbaum άρχισε να θέτει δύσκολες ερωτήσεις σε μια εποχή που ο τομέας της τεχνητής νοημοσύνης ήταν ακόμα σχετικά νέος και κυρίως γεμάτος αισιοδοξία. Πολλοί ερευνητές ονειρεύτηκαν να δημιουργήσουν έναν κόσμο όπου οι άνθρωποι και η τεχνολογία θα συμπορευθούν αρμονικά . Ήθελαν να δημιουργήσουν υπολογιστές που θα μπορούσαν να μιλήσουν μαζί μας και να ανταποκρίνονται στις ανάγκες και τις επιθυμίες μας. Ο Weizenbaum, εν τω μεταξύ, θα ακολουθούσε διαφορετικό δρόμο. Αρχιζε να μιλάει για το όριο μεταξύ ανθρώπων και μηχανών. Τελικά αποσπάστηκε από τους υποστηρικτές της τεχνητή νοημοσύνης και έγινε ο πρώτος (και πιο δυνατός) κριτικός της ίδιας της τεχνολογίας που βοήθησε να χτιστεί.

Παρά τα μεγάλα άλματα των υπολογιστών προς τα εμπρός, υπήρχε κάτι που αποδείχθηκε ιδιαίτερα δύσκολο για τους υπολογιστές. Προσπάθησαν να επεξεργασθούν την ανθρώπινη γλώσσα, η οποία στον τομέα της τεχνητής νοημοσύνης ονομάζεται συχνά «φυσική γλώσσα». Όπως εξηγεί η επιστήμονας υπολογιστών Melanie Mitchell, «Η επεξεργασία φυσικής γλώσσας είναι πιθανώς το πιο δύσκολο πρόβλημα για την τεχνητή νοημοσύνη, και ο λόγος είναι ότι η γλώσσα είναι σχεδόν- κατά κάποιο τρόπο- ισοδύναμη με τη σκέψη». Η χρήση της γλώσσας συγκεντρώνει όλες τις γνώσεις μας σχετικά με τον τρόπο λειτουργίας του κόσμου, συμπεριλαμβανομένης της κατανόησης των άλλων ανθρώπων και την διαισθητική μας αίσθηση για θεμελιώδες έννοιες. Για παράδειγμα, η Μίτσελ παρουσιάζει τη φράση «μια χαλύβδινη σφαίρα έπεσε πάνω σε ένα τραπέζι και το εσπασε». Οι άνθρωποι, σημειώνει, καταλαβαίνουν αμέσως ότι «αναφέρεται» σε γυάλινο τραπέζι. Οι μηχανές, αντίθετα, μπορεί να μην έχουν επαρκείς γνώσεις με βάση τα συμφραζόμενα σχετικά με τα υλικά και τη φυσική για να φτάσουν στο ίδιο αντικείμενο. Για τους ανθρώπους, εξηγεί, είναι λογικό.

Αυτή η αδεξιότητα των υπολογιστών με την ανθρώπινη γλώσσα σήμαινε ότι τα πρώτα chatbots, που χτίστηκαν στη δεκαετία του 1950 και του 60, ήταν περιορισμένα. Θα μπορούσαν να συζητήσουν για κάποιο πολύ συγκεκριμένο θέμα, όπως το μπέιζμπολ. Περιορίζοντας τον κόσμο των πιθανών ερωτήσεων και απαντήσεων, οι ερευνητές κατάφεραν να κατασκευάσουν μηχανές που πέρασαν ως «έξυπνες». Αλλά η συνομιλία μαζί τους ήταν σαν να συνομιλείτε με τη Wikipedia, όχι με πραγματικό πρόσωπο.

Λίγο μετά την άφιξη του Joseph Weizenbaum στο MIT στη δεκαετία του 1960, άρχισε να επιλύεται το πρόβλημα της φυσικής γλώσσας. Συνειδητοποίησε ότι μπορούσε να δημιουργήσει ένα chatbot που δεν χρειάζεται πραγματικά να γνωρίζει τίποτα για τον κόσμο. Δεν θα επεξεργάζεται τα γεγονότα. Θα αντανακλούσε τον χρήστη, σαν καθρέφτης.

Ο Weizenbaum από καιρό ενδιαφερόταν για την ψυχολογία και αναγνώρισε ότι τα πρότυπα ομιλίας ενός θεραπευτή μπορεί να είναι εύκολο να αυτοματοποιηθούν. Τα αποτελέσματα, ωστόσο, τον αναστάτωσαν. Οι άνθρωποι φάνηκαν να έχουν ουσιαστικές συνομιλίες με κάτι που δεν είχε ποτέ σκοπό να είναι ένα θεραπευτικό εργαλείο. Σε άλλους, όμως, αυτό φάνηκε να ανοίγει έναν ολόκληρο κόσμο δυνατοτήτων.

Πριν έρθει στο MIT, ο Weizenbaum είχε περάσει χρόνο στο Στάνφορντ, όπου έγινε φίλος με έναν ψυχίατρο με το όνομα Dr. Kenneth Colby. Ο Colby είχε εργαστεί σε ένα μεγάλο νοσοκομείο όπου οι ασθενείς ήταν τυχεροί που έβλεπαν έναν θεραπευτή μία φορά το μήνα. Είδε δυνατότητες στην ELIZA και άρχισε να προωθεί την ιδέα ότι το πρόγραμμα θα μπορούσε πραγματικά να είναι θεραπευτικά χρήσιμο. Η ιατρική κοινότητα άρχισε να δίνει προσοχή. Σκέφτηκαν ότι ίσως αυτό το πρόγραμμα – και άλλα σαν αυτό – θα μπορούσε να βοηθήσει στην επέκταση της πρόσβασης στην ψυχική υγειονομική περίθαλψη. Και θα μπορούσε ακόμη και να έχει πλεονεκτήματα έναντι ενός ανθρώπου θεραπευτή. Θα ήταν φθηνότερο και οι άνθρωποι θα μπορούσαν να μιλήσουν πιο ελεύθερα με ένα ρομπότ. Επιστήμονες μελλοντικής σκέψης όπως ο Carl Sagan έγραψαν για την ιδέα, στην περίπτωσή του να φαντάζονται ένα δίκτυο ψυχοθεραπευτικών τερματικών υπολογιστών σε πόλεις.

Και ενώ η ιδέα των τερματικών θεραπείας σε κάθε γωνιά δεν υλοποιήθηκε ποτέ, οι άνθρωποι που εργάζονταν στην ψυχική υγεία θα συνέχιζαν να πειραματίζονται με τον τρόπο χρήσης υπολογιστών στη δουλειά τους. Ο Colby συνέχισε να δημιουργεί ένα chatbot που ονομάζεται PARRY, το οποίο προσομοίωσε το στυλ συνομιλίας ενός ατόμου με παρανοϊκή σχιζοφρένεια. Αργότερα ανέπτυξε ένα διαδραστικό πρόγραμμα που ονομάζεται «Υπέρβαση της κατάθλιψης».

Ο Weizenbaum, από την πλευρά του, απομακρύνθηκε από τις δυσμενείς επιπτώσεις του δικού του έργου. Αντιτάχθηκε στην ιδέα ότι κάτι τόσο λεπτό, οικείο και ανθρώπινο όσο η θεραπεία θα μπορούσε να ξεπέσει τόσο. Άρχισε να υποστηρίζει ότι πεδία που απαιτούν ανθρώπινη συμπόνια και κατανόηση δεν πρέπει να είναι αυτοματοποιημένα. Και ανησυχούσε επίσης για το ίδιο μέλλον που είχε περιγράψει ο Άλαν Τούρινγκ – εκεί όπου τα chatbots εξαπατούσαν τακτικά τους ανθρώπους να σκέφτονται ότι ήταν άνθρωποι- Ο Weizenbaum τελικά θα έγραφε για την ELIZA. «Αυτό που δεν είχα συνειδητοποιήσει είναι ότι εξαιρετικά σύντομες εκθέσεις σε ένα σχετικά απλό πρόγραμμα υπολογιστή θα μπορούσαν να προκαλέσουν ισχυρή παραληρητική σκέψη σε αρκετά φυσιολογικούς ανθρώπους».

Ο Weizenbaum πήγε από κάποιον που εργάζεται στην καρδιά της κοινότητας AI στο MIT σε κάποιον που κηρύττει εναντίον του. Όταν κάποιοι είδαν θεραπευτικό δυναμικό, είδε μια επικίνδυνη ψευδαίσθηση συμπόνιας που θα μπορούσε να λυγίσει και να χρησιμοποιηθεί από κυβερνήσεις και εταιρείες.

Τις επόμενες δεκαετίες, τα λεγόμενα «συστήματα εμπειρογνωμόνων» άρχισαν να εμφανίζονται σε τομείς όπως η ιατρική, η νομοθεσία και τα οικονομικά. Τελικά, οι ερευνητές άρχισαν να προσπαθούν να δημιουργήσουν υπολογιστές που ήταν αρκετά εξελιγμένοι για να ΄΄γνωρίζουν ‘’ περισσότερο τον άνθρωπο .

Στη δεκαετία του 1980 και του 90, υπήρξαν νέες ανακαλύψεις στην επεξεργασία φυσικής γλώσσας. Οι επιστήμονες άρχισαν να βασίζονται σε στατιστικές μεθόδους, να λαμβάνουν έγγραφα και να αναλύουν τα γλωσσικά πρότυπα. Στη συνέχεια, στη δεκαετία του 2000 και του 2010, οι ερευνητές άρχισαν να χρησιμοποιούν αυτό που ονομάζεται «βαθιά νευρωνικά δίκτυα», εκπαιδεύοντας υπολογιστές , χρησιμοποιώντας τις τεράστιες ποσότητες δεδομένων που έγιναν προσβάσιμα με την έκρηξη του Διαδικτύου. Κοιτάζοντας όλα τα είδη γλώσσας στον Ιστό, οι υπολογιστές θα μπορούσαν να μάθουν πολύ πιο γρήγορα από ό, τι απλώς εάν προγραμματίζονταν με ένα βήμα τη φορά. Αυτές οι τεχνικές έχουν εφαρμοστεί ειδικά στα chatbots. Μερικοί ερευνητές εκπαιδεύουν τα chatbots τους σε καταγεγραμμένες συνομιλίες. Μερικοί βάζουν τα chatbots τους στο διαδίκτυο και μαθαίνουν καθώς αλληλεπιδρούν απευθείας με τους χρήστες.

Παρά τις προόδους αυτές, τα σύγχρονα chatbots – και τα ξαδέλφια τους που μιλούν, όπως η Siri και η Alexa – δεν μπορούν να «καταλάβουν» τις έννοιες ,με τον τρόπο που τις κατανοούμε. Αλλά ακόμη και αν η συνομιλία AI εξακολουθεί να μην έχει κοινή λογική, έχουν γίνει πολύ πιο αξιόπιστα, ευπαρουσίαστα και πειστικά. Υπάρχουν πρόσφατα παραδείγματα που το κάνουν να νιώθουμε σαν να ζούμε σταθερά στον κόσμο που πρόβλεψε ο Άλαν Τούρινγκ – οι μηχανές σήμερα ξεγελούν τους ανθρώπους -. Το 2018, για παράδειγμα, η Google αποκάλυψε ένα AI που ονομάζεται Duplex που μπορεί να κάνει κρατήσεις στο τηλέφωνο – πρόσθεσε ακόμη και τραύλισμα για να ακούγεται πιο πειστικό. Σε ορισμένους, αυτό ήταν ανησυχητικό – ειδικότερα, η αδυναμία των χρηστών να πει με βεβαιότητα εάν μιλούσαν με έναν άνθρωπο ή μια μηχανή.

Ο Joseph Weizenbaum αποσύρθηκε τελικά από το MIT, αλλά συνέχισε να μιλάει ενάντια στους κινδύνους της τεχνητής νοημοσύνης έως ότου πέθανε το 2008 στην ηλικία των 85 ετών. ..

Είμαστε τελικά γοητευμένοι που βλέπουμε τον εαυτό μας να αντανακλάται σε έξυπνες μηχανές η παραληρούντες ανόητοι ,μη φυσιολογικοί άνθρωποι ,από την επαφή μας με άψυχες μηχανές;

Eλεύθεροι η σκλάβοι μηχανών;

Η καλύτερα αρρωστημένων εγκεφάλων που τις επέβαλαν στην ζωή μας;

Που μας τρολάρουν και με Κάρτες;

Επιλεξτε να γινετε οι πρωτοι που θα εχετε προσβαση στην Πληροφορια του Stranger Voice

Ολοι οι Ελληνες πατριωτες επιλεγουν το Ελληνικο κοινωνικο δικτυο https://Hellasbook.gr ελα μαζι μας γιατι ειναι λογικο πια να μην ειμαστε στους ξενους!!

Θελεις να κανεις ενα δωρο στον εαυτο σου;

Δες την Κατηγορια με τα προιοντα μας

Γεγονός που δείχνει πόσο αναξιόπιστο είναι το τέστ του Άλαν Τούριγκ για την επίτευξη της τεχνητής νοημοσύνης. Αν ένα κομπιούτερ του 60 μπορούσε να ξεγελάει ανθρώπους λόγω της ανθρώπινης εφυίας που το είχε προγραμματίσει τόσο πειστικά. Φανταστείτε πως μπορούμε να ξεγελαστούμε σήμερα. Η Τεχνητή Νοημοσύνη θα χρησιμοποιηθεί σαν ένα ακόμα εργαλείο καταστολής.

Δυστυχώς, αν και είμαι άνθρωπος που δουλεύει με την τεχνολογία και λειτουργεί μέσα από αυτήν, έχω καταλήξει στο συμπέρασμα ότι η τεχνολογία έχει πάψει να μας υπηρετεί & να μας εξυπηρετεί και συμβαίνει εδώ και χρόνια το ακριβώς αντίστροφο. Εμείς υπηρετούμε την τεχνολογία και η ΝΤΠ φροντίζει να γινόμαστε όλο και πιο πιστοί σκλάβοι της. Είναι ώρα να κάνουμε πολλά βήματα ΠΙΣΩ & να αναθεωρήσουμε, να σκεφτούμε πολύ σοβαρά τι πραγματικά αρκεί για να μας εξυπηρετεί. Κυριολεκτικά, πουλάμε την ψυχή μας.