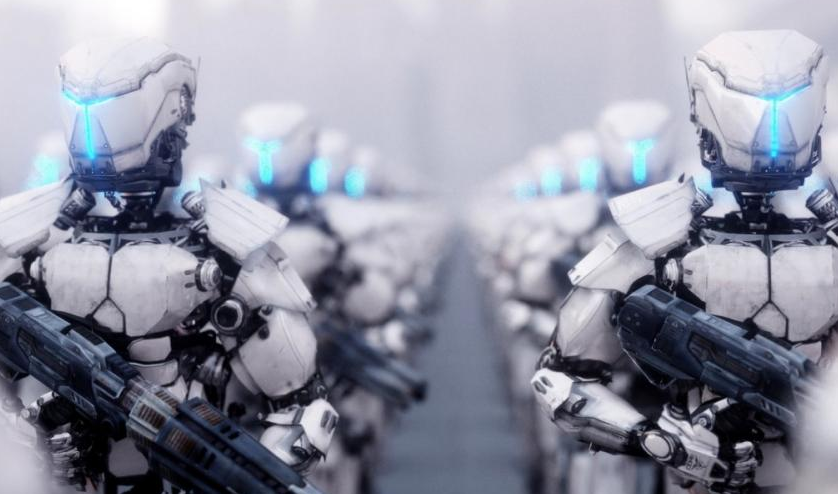

Τεχνητή νοημοσύνη & Ρομπότ Δολοφόνοι!

Η τεχνολογία αναγνώρισης προσώπου στον πόλεμο της Ουκρανίας, φέρνει πιο κοντά τα ρομπότ δολοφόνους;

Η Clearview AI προσφέρει την αμφιλεγόμενη τεχνολογία της στην Ουκρανία για τον εντοπισμό εχθρικών στρατιωτών – ενώ οι αυτόνομες μηχανές δολοφονίας αυξάνονται.

Η τεχνολογία που μπορεί να αναγνωρίσει τα πρόσωπα των εχθρικών μαχητών είναι η πιο πρόσφατη ανακάλυψη που έχει αναπτυχθεί στο πολεμικό θέατρο της Ουκρανίας. Αυτή η στρατιωτική χρήση της τεχνητής νοημοσύνης έχει όλα τα σημάδια μιας περαιτέρω δυστοπικής πορείας σε μια ήδη βάναυση σύγκρουση.

Η Αμερικανική εταιρεία Clearview AI προσέφερε στην Ουκρανική κυβέρνηση δωρεάν χρήση της αμφιλεγόμενης τεχνολογίας αναγνώρισης προσώπου. Προσφέρθηκε για την αποκάλυψη διεισδυτικών – συμπεριλαμβανομένου του Ρωσικού στρατιωτικού προσωπικού – την καταπολέμηση της παραπληροφόρησης, την αναγνώριση των νεκρών και την επανένωση των προσφύγων με τις οικογένειές τους.

Μέχρι σήμερα, δημοσιεύματα των μέσων ενημέρωσης και δηλώσεις αξιωματούχων της Ουκρανικής κυβέρνησης έχουν υποστηρίξει ότι η χρήση των εργαλείων της Clearview περιορίστηκε στην αναγνώριση νεκρών Ρώσων στρατιωτών προκειμένου να ενημερωθούν οι οικογένειές τους, από ευγένεια. Ο Ουκρανικός στρατός φέρεται επίσης να χρησιμοποιεί το Clearview και για την ταυτοποίηση των δικών του θυμάτων.

Αυτή η συνεισφορά στην Ουκρανική πολεμική προσπάθεια θα προσφέρει στην εταιρεία ένα βάπτισμα του πυρός για το σημαντικότερο προϊόν της. Η ανάπτυξη του Battlefield θα προσφέρει στην εταιρεία το απόλυτο stress test και θα αποφέρει πολύτιμα δεδομένα, μετατρέποντας αμέσως το Clearview AI σε πολεμικό εργολάβο και περιζήτητο εργαλείο στην στρατιωτική τεχνολογία.

Εάν η τεχνολογία αυτή μπορεί να χρησιμοποιηθεί για τον εντοπισμό ζωντανών αλλά και νεκρών εχθρικών στρατιωτών, θα μπορούσε επίσης να ενσωματωθεί σε συστήματα που χρησιμοποιούν αυτοματοποιημένη λήψη αποφάσεων για να κατευθύνουν θανατηφόρες κινήσεις. Αυτό δεν είναι φανταστικό ενδεχόμενο. Πέρυσι, ο ΟΗΕ ανέφερε ότι ένα αυτόνομο drone σκότωσε ανθρώπους στην Λιβύη το 2020 και υπάρχουν ανεπιβεβαίωτες αναφορές για αυτόνομα όπλα που χρησιμοποιούνται ήδη στο θέατρο της Ουκρανίας.

Η ανησυχία μας είναι ότι αν η Ουκρανία βγει νικήτρια από αυτό που είναι ένας δολοφονικός επιθετικός πόλεμος μπορεί να θολώσει το όραμα και την κρίση σχετικά με το επικίνδυνο προηγούμενο που δημιουργήθηκε από τις δοκιμές στο πεδίο της μάχης και την βελτίωση της τεχνολογίας αναγνώρισης προσώπου, η οποία θα μπορούσε στο εγγύς μέλλον να ενσωματωθεί σε αυτόνομες φονικές μηχανές.

Για να είμαστε σαφείς, αυτή η χρήση είναι εκτός της αρμοδιότητας της τρέχουσας υποστήριξης της Clearview στον Ουκρανικό στρατό και από όσο γνωρίζουμε η Clearview δεν έχει εκφράσει ποτέ καμία πρόθεση να χρησιμοποιηθεί η τεχνολογία της με τέτοιο τρόπο. Ωστόσο, πιστεύουμε ότι υπάρχει πραγματικός λόγος ανησυχίας όσον αφορά την στρατιωτική και πολιτική χρήση των ιδιωτικών τεχνολογιών αναγνώρισης προσώπου.

Η υπόσχεση που δίνει η εταιρεία αναγνώρισης προσώπου στην επιβολή του νόμου και στο πεδίο της μάχης είναι να αυξήσει την ακρίβεια, αίροντας την παροιμιώδη ομίχλη του πολέμου με την αυτοματοποιημένη ακριβή στόχευση, βελτιώνοντας την αποτελεσματικότητα της θανατηφόρας βίας, ενώ παράλληλα θα γλιτώσει τις ζωές των “αθώων”.

Τα συστήματα αυτά φέρνουν τα δικά τους προβλήματα.

Η λανθασμένη αναγνώριση είναι ένα προφανές γεγονός, και παραμένει μια σοβαρή ανησυχία, μεταξύ άλλων κατά την αναγνώριση νεκρών ή τραυματισμένων στρατιωτών. Εξίσου σοβαρό είναι ότι για λόγους αποτελεσματικότητας, οι αποφάσεις στο πεδίο της μάχης με θανατηφόρες συνέπειες είναι πιθανό να γίνονται όλο και περισσότερο “μαύρα κουτιά” – όταν λαμβάνονται από μια μηχανή της οποίας η λειτουργία και οι αποφάσεις είναι αδιαφανείς ακόμη και για τον χειριστή της. Εάν τα αυτόνομα οπλικά συστήματα ενσωματώνουν ιδιωτικές τεχνολογίες και βάσεις δεδομένων, αυτές οι αποφάσεις θα λαμβάνονταν αναπόφευκτα, εν μέρει, από ιδιόκτητους αλγόριθμους που ανήκουν στην εταιρεία.

Η Clearview δικαίως επιμένει ότι το εργαλείο της πρέπει να συμπληρώνει και όχι να αντικαθιστά την ανθρώπινη λήψη αποφάσεων. Ο Διευθύνων Σύμβουλος της εταιρείας ανέφερε επίσης σε δήλωση του, ότι όλοι όσοι έχουν πρόσβαση στην τεχνολογία της «εκπαιδεύονται στο πώς να την χρησιμοποιούν με ασφάλεια και υπευθυνότητα». Καλό σαν σκεπτικό μα έντονα αμφισβητήσιμο.

Η σύνεση και οι διασφαλίσεις όπως αυτή, είναι βέβαιο ότι θα εγκαταλειφθούν γρήγορα στον πυρετό της μάχης.

Τα συστήματα της Clearview χρησιμοποιούνται ήδη από αστυνομικές και ιδιωτικές επιχειρήσεις ασφάλειας – είναι γνωστά στα αστυνομικά τμήματα των ΗΠΑ, για παράδειγμα. Η κριτική αυτής της χρήσης έχει επικεντρωθεί σε μεγάλο βαθμό στην μεροληψία και την εσφαλμένη αναγνώριση στόχων, καθώς και στην υπερβολική εξάρτηση από τον αλγόριθμο για την πραγματοποίηση ταυτοποιήσεων – αλλά ο κίνδυνος είναι και αντίστροφος.

Παρά τους ισχυρισμούς των ηγετών, τα πυρηνικά όπλα δεν εμποδίζουν τον πόλεμο ούτε κάνουν την ζωή πιο ασφαλή ή πιο ειρηνική αλλά θέτουν σε κίνδυνο την επιβίωση ολόκληρου του πλανήτη.

Όσο πιο ακριβές είναι στην πραγματικότητα αυτό το εργαλείο, τόσο πιο πιθανό είναι να ενσωματωθεί σε αυτόνομα οπλικά συστήματα που μπορούν να στραφούν όχι μόνο σε στρατούς εισβολής αλλά και σε πολιτικούς αντιπάλους, μέλη συγκεκριμένων εθνοτικών ομάδων κ.λπ. Αν μη τι άλλο, η βελτίωση της αξιοπιστίας της τεχνολογίας την καθιστά ακόμη πιο απαίσια και επικίνδυνη. Αυτό δεν ισχύει μόνο για την ιδιωτική τεχνολογία, αλλά και για τις προσπάθειες κρατών όπως η Κίνα να αναπτύξουν εργαλεία αναγνώρισης προσώπου για χρήση ασφαλείας.

Εκτός μάχης, επίσης, η χρήση της τεχνητής νοημοσύνης αναγνώρισης προσώπου στον πόλεμο της Ουκρανίας εγκυμονεί σημαντικούς κινδύνους. Όταν η αναγνώριση προσώπου χρησιμοποιείται στην ΕΕ για σκοπούς ελέγχου των συνόρων και μετανάστευσης –και είναι ευρέως γνωστό– οι δημόσιες αρχές είναι αυτές που συλλέγουν τα ευαίσθητα δεδομένα βιοδεικτών που είναι απαραίτητα για την αναγνώριση προσώπου, το υποκείμενο των δεδομένων γνωρίζει ότι συμβαίνει και η νομοθεσία της ΕΕ ρυθμίζει αυστηρά την διαδικασία.

Η Clearview, αντίθετα, έχει ήδη παραβεί επανειλημμένα τον GDPR (Γενικός Κανονισμός για την Προστασία Δεδομένων) της ΕΕ και της έχουν επιβληθεί αυστηρές κυρώσεις από υπηρεσίες ασφαλείας δεδομένων στην Ιταλία και την Γαλλία.

Εάν χρησιμοποιούνται ιδιωτικές τεχνολογίες αναγνώρισης προσώπου για την αναγνώριση Ουκρανών πολιτών εντός της ΕΕ ή σε παραμεθόριες ζώνες, για να τους προσφέρεται κάποια μορφή προστατευτικού καθεστώτος, θα δημιουργηθεί μια γκρίζα ζώνη μεταξύ στρατιωτικής και πολιτικής χρήσης εντός της ίδιας της ΕΕ.

Οποιοδήποτε τέτοιο σύστημα αναγνώρισης προσώπου θα μπορούσε να χρησιμοποιείται σε άμαχους πληθυσμούς εντός της ΕΕ.

Μια εταιρεία όπως η Clearview θα μπορούσε να υποσχεθεί πως θα διατηρήσει τις βάσεις δεδομένων της για πολιτικές και στρατιωτικές βάσεις χωριστές, αλλά αυτό θα χρειαζόταν περαιτέρω ρύθμιση – και ακόμη και τότε θα έθετε το ερώτημα πώς μπορεί να ανατεθούν σε μια εταιρεία δεδομένα πολιτικού χαρακτήρα που μπορεί εύκολα να επαναχρησιμοποιήσει για στρατιωτική χρήση;

Αυτό είναι στην πραγματικότητα που προσφέρει ήδη η Clearview στην Ουκρανική κυβέρνηση: χτίζει την επιχείρηση αναγνώρισης της πρώτης γραμμής της στρατιωτικής της γραμμής με βάση δεδομένα πολιτών που συλλέγονται από Ρωσικά αρχεία κοινωνικών δικτύων.

Έπειτα υπάρχει το ζήτημα της κρατικής και σκιώδους εξουσίας.

Μόλις βγει από το κουτί, η αναγνώριση προσώπου μπορεί να αποδειχθεί πολύ δελεαστική για τις ευρωπαϊκές υπηρεσίες ασφαλείας ώστε να μην την χρησιμοποιήσουν. Αυτό έχει ήδη αναφερθεί στις ΗΠΑ, όπου τα μέλη του Αστυνομικού Τμήματος της Νέας Υόρκης αναφέρεται ότι χρησιμοποίησαν το εργαλείο της Clearview για να παρακάμψουν τους κανόνες προστασίας δεδομένων και απορρήτου εντός του τμήματος κι ότι έχουν εγκαταστήσει την εφαρμογή του Clearview σε ιδιωτικές συσκευές κατά παράβαση της πολιτικής της NYPD.

Αυτός είναι ένας ιδιαίτερος κίνδυνος σε σχέση με την ανάπτυξη και τις δοκιμές στην Ουκρανία. Εάν η ένταξη της Ουκρανίας στην Ευρωπαϊκή Ένωση γίνει γρήγορα, όπως πολλοί υποστηρίζουν ότι θα γίνει, θα μεταφέρει στην ΕΕ την χρήση της τεχνητής νοημοσύνης της Clearview ως καθιερωμένη πρακτική για στρατιωτική και δυνητικά πολιτική χρήση και ενώ αρχικά επινοήθηκαν χωρίς δόλο ή πρόθεση κακής χρήσης, πρέπει να θέσουμε το γεγονός πως είναι ανησυχητικό.

Η Ρωσική εισβολή στην Ουκρανία είναι ασυνήθιστη ως προς το μέγεθος και την βαναυσότητά της. Αλλά η προσοχή στον άνεμο δεν αποτελεί νόμιμο δόγμα για τους νόμους του πολέμου ή τους κανόνες εμπλοκής- αυτό ισχύει ιδιαίτερα όταν πρόκειται για ισχυρή νέα τεχνολογία AI. Η άμυνα της Ουκρανίας μπορεί κάλλιστα να περιλαμβάνει εργαλεία και μεθόδους που, εάν ομαλοποιηθούν, θα υπονομεύσουν τελικά την ειρήνη και την ασφάλεια των Ευρωπαίων πολιτών στο εσωτερικό και στα μελλοντικά μέτωπα.

Οι πολιτικοί της ΕΕ θα πρέπει να είναι επιφυλακτικοί. Η ΕΕ πρέπει να χρησιμοποιήσει όλα τα εργαλεία που έχει στην διάθεσή της για να τερματίσει την σύγκρουση στην Ουκρανία, αλλά πρέπει να το πράξει διασφαλίζοντας το κράτος δικαίου και την προστασία των πολιτών της.

Η ΕΕ θα πρέπει να επικεντρωθεί εκ νέου στον νόμο AI για τους εργαζόμενους και τους ανθρώπους.

Η προτεινόμενη νομοθεσία της ΕΕ για την τεχνητή νοημοσύνη καθοδηγείται από την επιθυμία για ανάπτυξη, με λίγες διατάξεις για την διασφάλιση των δικαιωμάτων των ατόμων, ιδιαίτερα των εργαζομένων.

Τον Απρίλιο του 2021, η Ευρωπαϊκή Επιτροπή πρότεινε τον νόμο περί τεχνητής νοημοσύνης, ο οποίος στοχεύει στην ρύθμιση της χρήσης προϊόντων, υπηρεσιών και συστημάτων που βασίζονται σε τεχνητή νοημοσύνη εντός της ΕΕ. Ωστόσο, το σχέδιο νόμου με γνώμονα την αγορά, με στόχο την δημιουργία και την ανάπτυξη ενός ανταγωνιστικού ευρωπαϊκού τομέα τεχνητής νοημοσύνης, απέτυχε να ανταποκριθεί στις προσδοκίες της κοινωνίας των πολιτών, η οποία ήλπιζε ότι η πράξη θα έδινε προτεραιότητα στην προστασία των ανθρώπων.

Η Προεδρία του Συμβουλίου της ΕΕ επέκρινε επίσης το κείμενο, προβάλλοντας ουσιαστικές αλλαγές στην πρόταση και προτείνοντας, ειδικότερα, περαιτέρω περιορισμούς στην πιθανή χρήση ενός «συστήματος κοινωνικής πίστωσης» και τεχνολογίας αναγνώρισης προσώπου. Οι κρίσιμες διαπραγματεύσεις βρίσκονται σε εξέλιξη, αλλά δεν υπάρχει καμία εγγύηση ότι θα έχουν ως αποτέλεσμα το σχέδιο νόμου να γίνει πιο προστατευτικό για τους ανθρώπους.

Η απασχόληση και τα δικαιώματα των εργαζομένων αποτελούν ιδιαίτερους τομείς ανησυχίας στο πλαίσιο του νόμου περί τεχνητής νοημοσύνης και πρέπει να ληφθούν μέτρα για να διασφαλιστεί η προστασία των εργαζομένων.

AI στον χώρο εργασίας.

Όταν λειτουργούν, τα συστήματα AI κάνουν αυτό που τους ζητάμε: να επιτύχουν έναν στόχο. Όμως, είναι εύκολο να δώσεις σε ένα σύστημα τεχνητής νοημοσύνης το λάθος πρόβλημα για επίλυση ή να παράγει λύσεις που είναι άχρηστες, λανθασμένες ή προκατειλημμένες. Αυτό που δεν είναι τόσο εύκολο είναι να εντοπίσετε προβλήματα όπως αυτό πριν κάτι πάει στραβά. Καθώς στα συστήματα τεχνητής νοημοσύνης ανατίθεται αυξανόμενη «εξουσία» στον χώρο εργασίας και στις διαδικασίες πρόσληψης, για παράδειγμα η εξέταση βιογραφικών και η εκτίμηση του «επιπέδου κινδύνου» των εργαζομένων, πρέπει να αναρωτηθούμε εάν οι προγραμματιστές μπορούν να δημιουργήσουν συστήματα τεχνητής νοημοσύνης που να προστατεύουν τα δικαιώματα των εργαζομένων όταν οι στόχοι του συστήματος δεν έχουν καμία σχέση με αυτά τα δικαιώματα.

Πώς μπορούμε να θέσουμε όρια σε ένα σύστημα που έχει αρνητικό αντίκτυπο στους εργαζόμενους και τα δικαιώματά τους;

Δεδομένων αυτών των ερωτημάτων και των ιδιαίτερων κινδύνων που εγείρει η τεχνητή νοημοσύνη στο πλαίσιο της απασχόλησης, η Ευρωπαϊκή Επιτροπή θα πρέπει να εκπονήσει μια πρόσθετη νομοθετική πρόταση αφιερωμένη στην προστασία των δικαιωμάτων των εργαζομένων όταν εκτίθενται, αλληλεπιδρούν ή εργάζονται με συστήματα τεχνητής νοημοσύνης.

Με ορισμένες τροποποιήσεις, ο τελικός νόμος για την τεχνητή νοημοσύνη θα μπορούσε –και θα έπρεπε– να γίνει ένα λιγότερο επιτρεπτό εργαλείο ρύθμισης της αγοράς, σε σύγκριση με την τρέχουσα έκδοσή του, που αντιμετωπίζει ζητήματα που σχετίζονται με τον αντίκτυπο της τεχνητής νοημοσύνης στους εργαζόμενους, οι οποίοι κινδυνεύουν ιδιαίτερα λόγω της δευτερεύουσας θέσης τους στην σχέση εργασίας.

Ως έχει, ο προτεινόμενος νόμος για την τεχνητή νοημοσύνη δεν ρυθμίζει την τεχνητή νοημοσύνη. Αυτό που κάνει είναι να θεσπίζει κανόνες σχετικά με την διάθεση «συστημάτων AI» στην αγορά και την θέση τους σε λειτουργία και χρήση.

Είναι σαφές από το προσχέδιο ότι ο πρωταρχικός στόχος της Ευρωπαϊκής Επιτροπής είναι να προωθήσει την ανάπτυξη και την υιοθέτηση της τεχνητής νοημοσύνης για την οικονομική ανάπτυξη. Εν τω μεταξύ, η προστασία του δημόσιου συμφέροντος, ιδίως της υγείας, της ασφάλειας και των θεμελιωδών δικαιωμάτων και ελευθεριών των ατόμων, είναι μόνο ένας παράπλευρος στόχος και το σχέδιο περιλαμβάνει μόνο περιορισμένο αριθμό συγκεκριμένων διατάξεων για την επίτευξη αυτών των στόχων.

Ζητήματα που πρέπει να αντιμετωπίσει το προσχέδιο.

Ενημέρωση και εκσυγχρονισμός της κατανόησης των κινδύνων που σχετίζονται με την εργασία, ώστε να συμπεριληφθούν οι κίνδυνοι που βασίζονται σε δεδομένα ή οι κίνδυνοι που σχετίζονται με την τεχνητή νοημοσύνη. Αυτό θα συνεπαγόταν την διεξαγωγή μιας εκτεταμένης προληπτικής άσκησης με την συμμετοχή τόσο των εργοδοτών όσο και των εργαζομένων. Ο νέος τρόπος σκέψης για τους κινδύνους στον χώρο εργασίας πρέπει να είναι ευρύς και να υπερβαίνει την επαγγελματική υγεία και ασφάλεια. Θα πρέπει να περιλαμβάνει τους κινδύνους για την ιδιωτική ζωή, την προστασία των δεδομένων και τα θεμελιώδη δικαιώματα, καθώς και τις πιθανές καταχρήσεις της διοικητικής εξουσίας που απορρέουν από την σχέση εργασίας.

Το «παράδοξο της διαφάνειας» στην εργασία πρέπει να αντιμετωπιστεί. Η διαφάνεια δεν λειτουργεί στον χώρο εργασίας, καθώς είναι μια μονομερής απαίτηση που δεν παρέχει στους εργαζόμενους τα δικαιώματά τους. Καθώς οι εφαρμογές τεχνητής νοημοσύνης περιλαμβάνουν την επεξεργασία προσωπικών δεδομένων, συμπεριλαμβανομένων των δεδομένων των εργαζομένων, η επιβεβαίωση της συνάφειας των δικαιωμάτων GDPR και η σαφήνειά τους στο πλαίσιο της απασχόλησης είναι απαραίτητη. Τα συστήματα τεχνητής νοημοσύνης χρησιμοποιούν δεδομένα εργαζομένων για προγνωστική ανάλυση, αξιολόγηση απόδοσης ή διανομή εργασιών και οι εργαζόμενοι πρέπει να μπορούν να ασκούν πλήρως τα δικαιώματά τους βάσει του GDPR με τους εργοδότες τους.

Σύμφωνα με τον GDPR, οι εργαζόμενοι πρέπει να μπορούν να ασκούν ευκολότερα το δικαίωμά τους στην γνώση (άρθρο 22 GDPR) για τον τρόπο χρήσης των δεδομένων τους. Εάν οι εργαζόμενοι δεν κατανοούν πώς χρησιμοποιούνται τα δεδομένα τους για την διαχείριση και την αξιολόγησή τους, δεν μπορούν να λάβουν μέτρα για την προστασία των δικαιωμάτων τους.

Εξίσου σημαντικό είναι ότι οι εργαζόμενοι μπορούν να ασκήσουν το δικαίωμά τους για διαβούλευση. Αυτό μπορεί να συνεπάγεται την υποχρέωση για τους εργοδότες να συμβουλεύονται τους εργαζομένους πριν από την εφαρμογή συστημάτων τεχνητής νοημοσύνης και να παρέχουν έναν μηχανισμό για την παρακολούθηση των αποτελεσμάτων. Από εργασιακή σκοπιά, η προσπάθεια ενσωμάτωσης προστατευτικών διατάξεων στην πρόταση του νόμου περί τεχνητής νοημοσύνης μπορεί να αποδειχθεί σαν να προσπαθείς να σπρώξεις τετράγωνα μανταλάκια σε στρογγυλές τρύπες.

Επιβεβαίωση της αρχής «άνθρωπος στην εξουσία» ως στοιχείο της οργάνωσης της εργασίας και διατήρηση της αυτονομίας των εργαζομένων στις αλληλεπιδράσεις ανθρώπου-μηχανής. Στον χώρο εργασίας, άνθρωποι και μηχανές δρουν μαζί. Οι διευθυντές, η ομάδα υποστήριξης IT ή οι εξωτερικοί ειδικοί δεν μπορούν να είναι οι μόνοι άνθρωποι που αλληλεπιδρούν ενεργά και παρεμβαίνουν στα συστήματα AI. Όταν πραγματοποιείται από κοινού επίλυση προβλημάτων (ανθρώπου-μηχανής), οι εργοδότες θα πρέπει να διασφαλίζουν ότι τα συστήματα τεχνητής νοημοσύνης που αναπτύσσουν απαιτούν πάντα την αλληλεπίδραση των εργαζομένων, για παράδειγμα χρησιμοποιώντας βρόχους ανάδρασης ή συστήματα επικύρωσης και ενσωματώνοντας την γνώση και την κατανόηση των δικών τους ρόλων και καθηκόντων των εργαζομένων.

Πλήρης απαγόρευση αλγοριθμικής παρακολούθησης εργαζομένων. Τα συστήματα τεχνητής νοημοσύνης μπορούν να φέρουν την παρακολούθηση των εργαζομένων σε ένα νέο επίπεδο, το οποίο μπορεί να οριστεί ως «αλγοριθμική επιτήρηση εργαζομένων». Οι προηγμένες αναλύσεις μπορούν να χρησιμοποιηθούν για την μέτρηση της βιολογίας, των συμπεριφορών, της συγκέντρωσης και των συναισθημάτων. Κάποιος μπορεί να το συγκρίνει αυτό με την μετάβαση από το ραντάρ, το οποίο σαρώνει την επιφάνεια της θάλασσας, στο σόναρ, το οποίο δημιουργεί μια τρισδιάστατη εικόνα για οτιδήποτε βρίσκεται κάτω από την επιφάνεια. Αυτή η επιτήρηση είναι εξαιρετικά παρεμβατική, καθώς δεν σαρώνει παθητικά, αλλά «ξύνει» την προσωπική ζωή των εργαζομένων, χτίζοντας ενεργά μια εικόνα και στην συνέχεια λαμβάνοντας κρίσεις και αποφάσεις για άτομα. Πρέπει να απαγορευτεί.

Είναι η κατάλληλη στιγμή να θέσουμε θεμελιώδη ερωτήματα σχετικά με τον καλύτερο τρόπο αντιμετώπισης της διακυβέρνησης της τεχνητής νοημοσύνης, συμπεριλαμβανομένης της απαραίτητης ικανότητας αξιολόγησης των κινδύνων πριν από την εφαρμογή συστημάτων τεχνητής νοημοσύνης και αυτοί οι κίνδυνοι πραγματοποιηθούν στην πραγματικότητα.

Ο νόμος AI σχεδιάστηκε από την Ευρωπαϊκή Επιτροπή για να διασφαλίσει την ανάπτυξη μιας ανταγωνιστικής και «απορυθμισμένης» ευρωπαϊκής αγοράς τεχνητής νοημοσύνης. Απαιτείται όμως μια πιο ισορροπημένη προσέγγιση και στο Ευρωπαϊκό Κοινοβούλιο θα πρέπει να ακούσουν τις πολλές φωνές που ζητούν ένα ρυθμιστικό πλαίσιο που προστατεύει επίσης τα δικαιώματα των πολιτών και των εργαζομένων.

***

@GYPAS / 2021-2022

ψαχνουμε τ.ν. σε αυτά;;

παρατηρήστε τις διαφημίσεις στις στάσεις λεωφορειων… γραμματα γραμμένα απο τεχνητή νοημοσύνη… διαφημιστικά σοκολάτας…

τι διαφημιζεται στις “”στασεις”;; που το συνηθίζει το μάτι σου;; νοών νοείτο

Ξερεις κανεις ποιος ειναι αυτος που κανει την παρουσιαση; Για Ελληναςε μου ακουγεται απο την προφορα…

https://librti.com/view-video/remove-the-nanoparticles-from-your-body